复旦团队推出新框架破译甲骨文,大模型破译甲骨文创下新SOTA

发布时间:2025-09-08 16:56:03

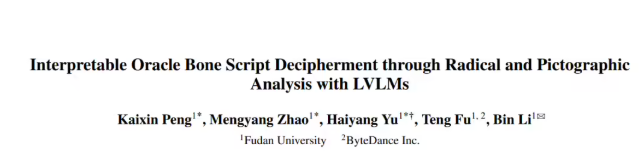

为破译甲骨文这一 “千古难题”,科技界与考古界携手攻坚。复旦大学团队基于大型视觉语言模型,打造出可解释甲骨文破译方法,通过部首分析和象形语义理解,填补字形与语意间的认知鸿沟。这一创新成果,不仅刷新公开基准数据集上的Top-10识别准确率,更是让大模型在零样本场景下也能对甲骨文精准 “解读”,助力揭开殷商历史神秘面纱 。

复旦团队推出新框架破译甲骨文

让大模型破译从未见过的甲骨文,准确率拿下新 SOTA!

来自复旦大学的研究人员提出了一种基于部首和象形分析的可解释甲骨文破译框架 —— 不仅在公开基准数据集 HUST-OBC 和 EV-OBC 上,达到最先进的 Top-10 识别准确率以及优异的零样本破译能力。

而且面对未破译甲骨文,所提方法也能够输出可解释性的分析文本,从而为考古破译工作提供潜在帮助。

事实上,作为最古老的成熟文字系统,甲骨文长期以来因其稀有性、抽象性和象形多样性,给考古破译工作带来了重大挑战。

当前基于深度学习的方法在甲骨文破译任务上取得了令人鼓舞的进展,但现有方法往往忽视了甲骨文字形与语义之间的复杂关联。

这导致了有限的泛化能力和可解释性,尤其是在处理零样本场景和未破译的甲骨文时。

为此,本文提出了一种基于大型视觉语言模型的可解释甲骨文破译方法,该方法通过联合部首分析与象形语义理解,弥合了甲骨文字形与语意之间的鸿沟。

下面具体来看 ——

首个象形解析甲骨文破译数据集

概括而言,团队提出了一种渐进式训练策略,引导模型从部首识别和部首分析,过渡到象形分析,最后进行部首-象形交互分析,从而实现从字形到字意的推理。

论文还设计了基于分析结果的“部首-象形双重匹配机制”,显著提升了模型的零样本破译性能。

为便于模型训练,论文提出了包含 47,157 个汉字的象形破译甲骨文数据集,其中部分汉字具有相应甲骨文图像和古代字体图像,所有汉字都具备现代楷书图像、部首分析和象形分析标注。

先说数据集。

尽管现有视觉语言大模型在多种任务上表现优异,但仍难以直接应用于甲骨文破译任务。

为解决这一挑战,论文提出了象形破译甲骨文(PD-OBS)数据集,用于训练具备甲骨文象形分析能力的视觉语言大模型,这对甲骨文破译任务具有重要意义。

PD-OBS 数据集共包含 47,157 个汉字。其中,3173 个汉字与从公开的 HUST-OBC 和 EVOBC 数据集收集的甲骨文图像相关联;10,968 个汉字提供了来自字形库的古代隶书图像;所有汉字均配有来自《汉典》的现代楷书图像。

除图像数据外,每个汉字均通过文本形式标注了部首分析和象形分析,这两者均与汉字的语义含义密切相关。

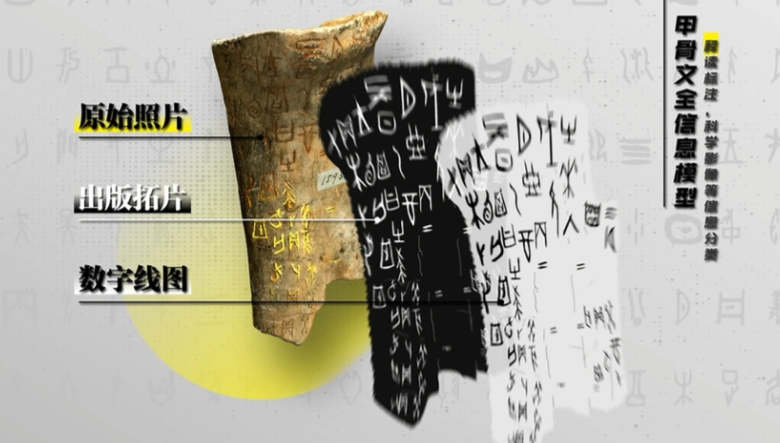

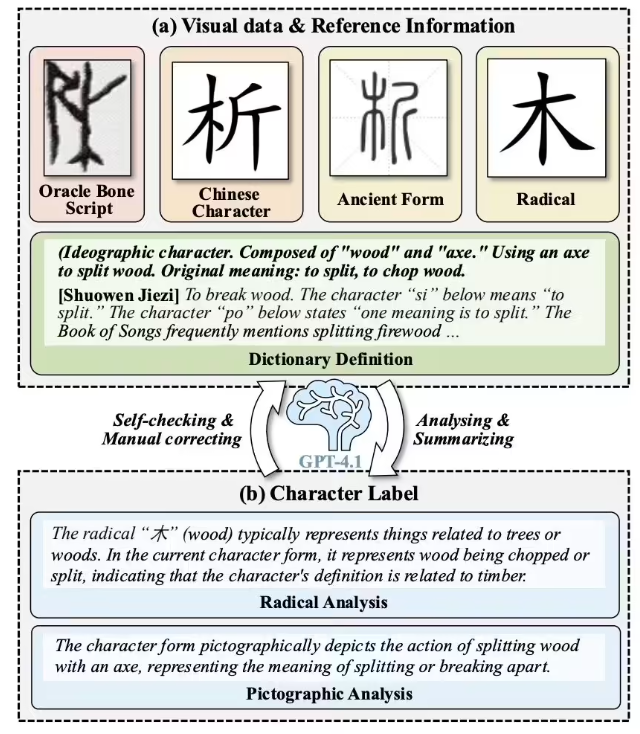

标注过程分为三个阶段,如图 1 所示。

首先,通过汉典从《说文解字》(一部古代汉语词典)中检索每个汉字的部首标签、定义及解释。

其次,将获取的部首标签及其解释与每个汉字的现代、古代字体和甲骨文图像关联。接着,利用 GPT-4.1 基于参考的字形图像丰富部首标签,并总结分析内容。

最后,通过 GPT-4.1 进行自我检查和人工修正来确保数据集的整体质量。

基于部首和象形分析的可解释甲骨文破译视觉语言大模型

1、模型整体结构

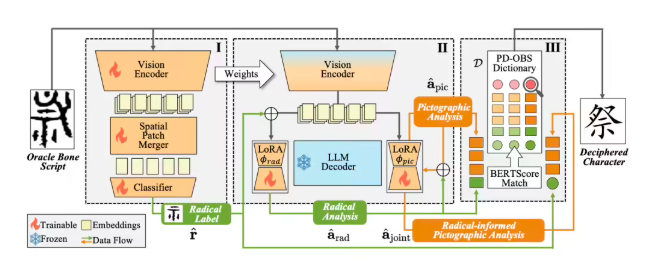

整体框架基于 Qwen2.5-VL-7B 构建,共享相同的视觉编码器和大型语言模型(LLM)。

如图 2 所示,研究人员引入了一个空间 patch 合并模块作为视觉适配器,以及一个分类器来预测部首标签,并且还提出了部首 LoRA 和象形 LoRA 模块来分析相应的信息。

此外,研究人员设计了一种渐进式训练方法,从部首识别开始,接着进行部首和象形分析,最终实现联合分析,以逐步引导模型完成甲骨文破译任务。

还提出了一个新颖的部首-象形双重匹配机制,以从数据库中选择最合适的字符。

2、部首识别

在本阶段,研究人员的目标是将视觉编码器适配于甲骨文的独特视觉风格,并预测用于下游推理的关键信息 —— 部首标签。

为此,团队设计了一个空间 patch 合并模块作为视觉适配器,该适配器将高维视觉特征压缩并聚合为预设维度的特征向量,作为甲骨文的抽象表示。

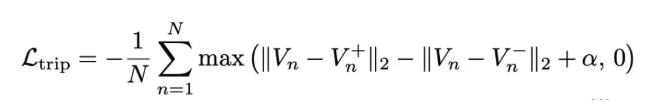

此外,研究人员基于欧式距离设计了一个三元组损失函数,以明确提升不同部首特征向量之间的区分度。

具体而言,团队实施了一种采样策略,确保每个批次中每个部首类别至少包含两个样本。

在训练过程中,对于批次中的每个样本,将它的特征向量 Vn 指定为锚点,然后选择一个正样本(即具有相同根部标签的样本)和一个负样本(即具有不同根部标签的样本)。

三元组损失如下:

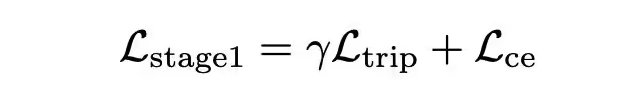

关于分类器,研究人员使用交叉熵损失来优化它。因此,本阶段的整个损失函数可以表示如下:

3、部首-象形联合分析

为了在甲骨文中实现字形与意义的关联,研究人员设计了一个渐进式的字形分析过程,以促进破译任务的完成。

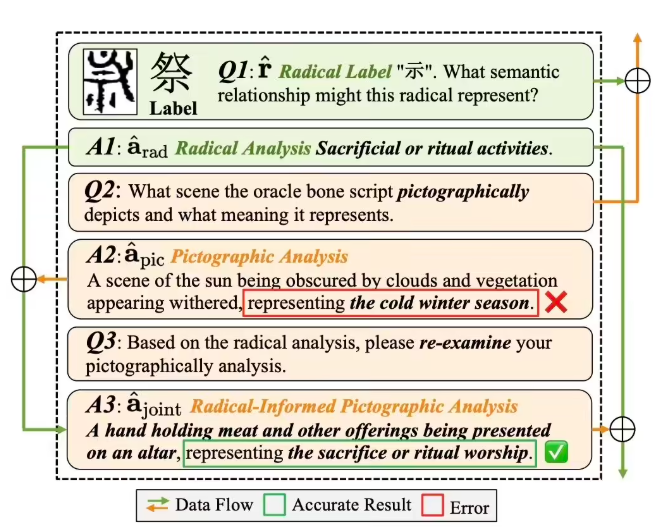

在甲骨文和古代汉字中,部首通常决定了字的基本语义,如图 3 中的 Q1&A1 所示。

因此,团队利用 PD-OBS 数据集构建的大量部首分析问答对对模型进行部首分析能力的训练。

接下来引导模型对整个字符进行象形分析,以分析字形蕴含的语意,如图 3 中的 Q2&A2 所示。

最后,研究人员设计了一个联合分析步骤,以解决仅凭象形分析可能无法直接预测正确对应现代汉字的情况。此步骤通过部首分析的结果指导象形分析,从而获得更准确的汉字含义,如图 3 中的 Q3&A3 所示。此阶段通过交叉熵损失来优化模型。

以下为部首-象形联合分析示意图:

4、部首-象形双重匹配机制

经过前两个阶段后,团队为每个测试字符生成了四个中间结果:预测的部首标签、部首分析、象形分析以及联合分析结果。

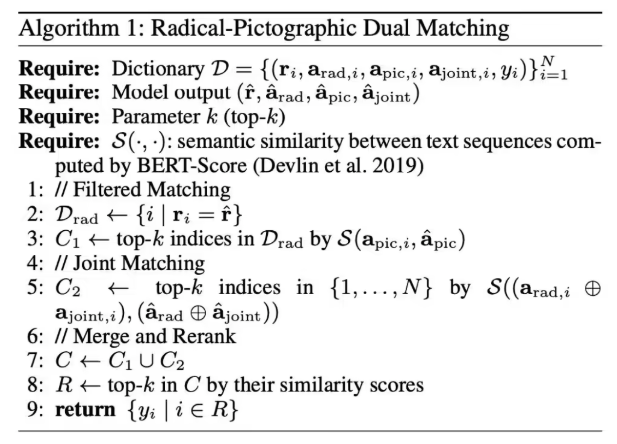

研究人员提出了一种基于词典的双重匹配机制用于破译。给定来自 PD-OBS 数据集的候选词典 D,该机制的工作流程如下:

首先,根据预测的部首标过滤候选项,然后根据象形分析之间的语义相似性选择前 k 个条目。

其次,将预测的部首分析与部首信息增强的象形分析结果进行拼接,并通过相似性进行排序。

最后,将这些候选集合并并重新排序,以获得前 k 个现代汉字作为破译结果。

所有步骤和符号在图 4 中详细说明。

值得注意的是,团队采用匹配机制而非直接输出破译结果,这有助于缓解模型在零样本设置下因训练数据中缺乏此类甲骨文而导致的泛化能力不足问题,以及未破译甲骨文带来的影响。

以下为部首象形双重匹配算法:

实验结果

1、验证集和零样本设定下的破译

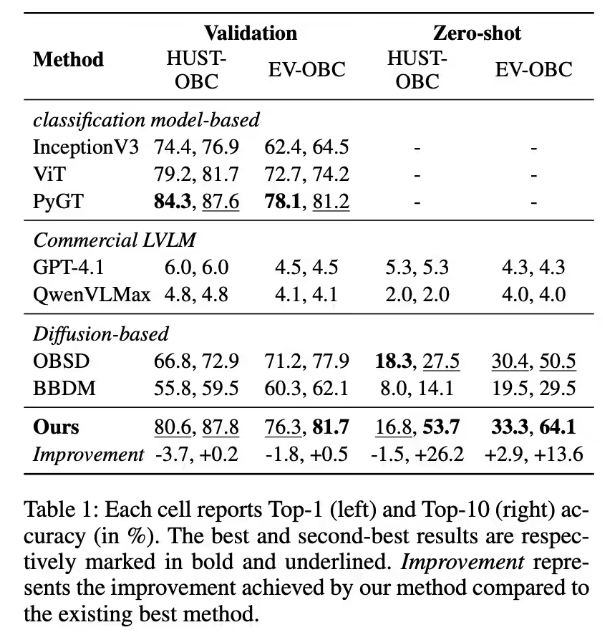

研究人员在 HUST-OBC 和 EV-OBC 数据集上对所提方法和现有方法进行了评估,从每个数据集中选取 200 个字符类别作为零样本测试集。

剩余数据以 9:1 的比例随机划分为训练集和验证集,以评估新框架及现有方法的甲骨文识别能力。

与先前研究一致,团队采用 Top-1 和 Top-10 准确率作为评估指标,该指标通常用于各类分类任务。

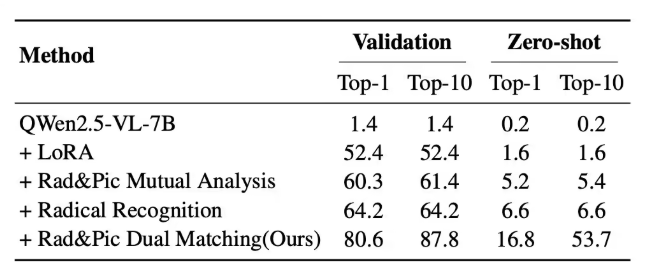

为了系统地评估新方法在甲骨文破译中的有效性,团队在两个基准数据集 HUST-OBC 和 EV-OBC 进行了全面比较,分别在验证集和零样本设置下进行,如表 1 所示。

注意,每个单元格分别显示 Top-1(左)和 Top-10(右)的准确率(%)。最佳结果和次佳结果分别以粗体和下划线标注。

团队采用 InceptionV3、ViT 和 PyGT 作为基于分类模型的代表方法,以及 OBSD 和 BBDM 作为基于扩散模型的代表方法。由于缺乏开源实现和数据集设置的不一致,现有基于组成式的方法目前未被纳入比较方法。

作为替代,研究人员纳入了强大的商用 LVLM,GPT-4.1 和 Qwen-VL-Max 用于比较。

相比之下,商用 LVLM 在两种设置下表现不佳,Top-1 准确率始终低于 6%,这说明了其理解古代文字视觉结构的能力受限。

在验证集上,尽管新方法的 Top-1 准确率略低于最佳分类模型基线(如 PyGT),但它实现了最高的 Top-10 准确率,展示了生成高质量候选项的优越能力,并提供了更大的实际用途。

在更具挑战性的零样本场景中,新方法表现出显著的优异性能:

在 Top-1 准确率方面仍具竞争力,并在 Top-10 准确率方面显著超越所有方法,在 HUST-OBC 数据集上比第二好的方法高出 26.2%,在 EV-OBC 数据集上则高出 13.6%。

这些结果证实了新方法在未见过的甲骨文上的强泛化能力和可迁移性,突显了其在考古研究中辅助识别未破译甲骨文方面的潜在价值。

2、破译的可解释性评估

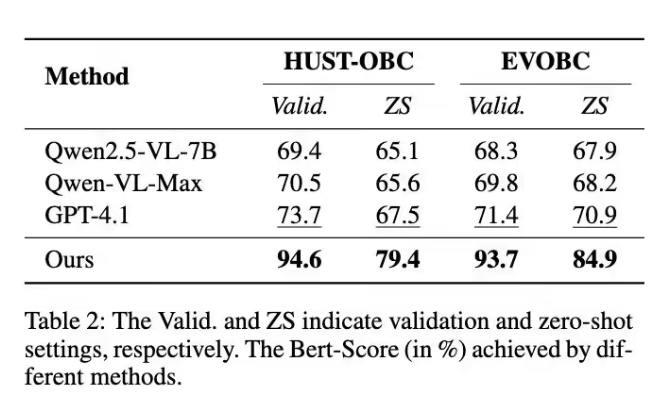

为了定量评估新方法生成的部首分析和象形分析的准确率,研究人员采用 BERT-Score 来衡量 Top-1 输出与字典 D 中真实分析标注之间的相似性。

团队还评估了其他大型视觉语言模型,包括 GPT-4.1、Qwen-VL-Max 和 Qwen2.5-VL-7B,并比较了它们在 HUST-OBC 和 EVOBC 数据集的验证集和零样本测试集的平均 BERT-Score。

如表 2 所示,新方法在验证集和零样本设置下,分别平均比最先进的 LVLM 模型 GPT-4.1 高出 21.60% 和 12.95%,在两个数据集上。

这一结果表明,新框架生成的分析结果更加可靠。

下表为,不同方法在验证集上获得的 Bert-Score(%)。Valid.和 S 分别表示验证集和零样本测试集。

3、消融实验

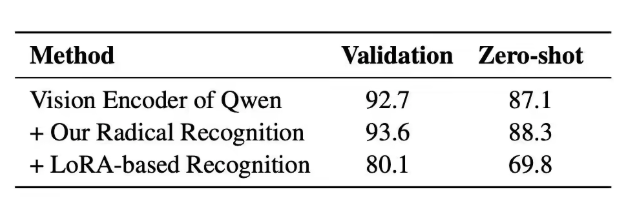

为了评估设计的部首识别阶段的有效性,研究人员以 Qwen2.5-VL-7B 的原始视觉编码器作为基线,并分别集成部首识别模块以及基于 LoRA 的识别方法。

其识别准确率在 HUST-OBS 数据集上进行了验证,并包含验证集和零样本设置。

新方法在基线视觉编码器上引入了空间补丁合并和损失函数 Ltrip,分别在验证集和零样本设置下实现了 0.9% 和 1.2% 的准确率提升。

基于 LoRA 的识别方法将识别阶段与部首分析过程合并,并采用基于 LoRA 的微调进行训练。

实验结果表明,该方法导致部首识别准确率显著下降,从而在部首分析中引入大量错误,因此研究人员在框架中将部首识别保留为独立阶段。

下表为,关于部首识别的消融实验结果:

为了验证团队提出的模块和策略的有效性,他们以 Qwen2.5-VL-7B 作为基线,并逐步添加每个组件以形成最终模型。

在验证集和零样本设置下的 Top-1 和 Top-10 性能如表 4 所示。

结果表明,LoRA 微调(+LoRA)在验证集上实现了基本的破译能力,但在零样本场景下仍缺乏泛化能力。

引入部首-象形互分析与部首识别后,模型在验证集上的准确率持续提升,但零样本能力的提升仍非常有限。

主要原因在于通过 LoRA 基于监督式微调训练的模型缺乏足够的泛化能力,常无法生成罕见字符 —— 这是零样本场景中的常见挑战。

为解决此问题,团队引入了部首-象形双匹配机制,以替代直接预测。

该策略不仅显著提升了模型的零样本性能,还增强了甲骨文中与语义无关的部首的鲁棒性,确保了解码结果的可靠性和可验证性。

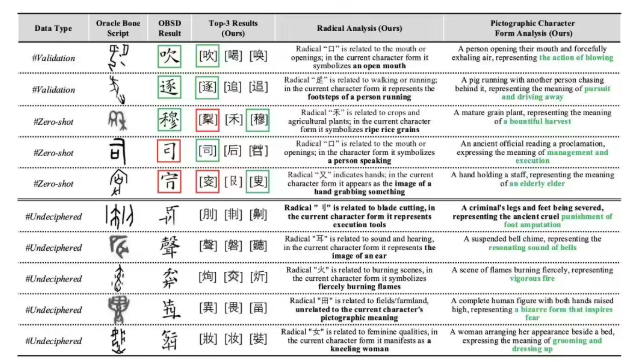

4、定性实验

图 5 展示了新方法以及 OBSD 方法在三种设置下的定性结果:验证集、零样本和未破译的甲骨文。

如图所示,团队的模型在验证集上展现出强大的识别能力,并在零样本设置下对未见过的甲骨文也具有良好的泛化能力。

更值得注意的是,对于人类专家尚未破译的字符,模型能够生成语义上合理的预测,并附带可解释的分析。

其设计的部首-象形相互分析在其中发挥了关键作用:部首分析追溯部首的结构起源,并解释其在当前字符形式中的象征功能。

同时,象形形式分析基于字符的整体形状和隐含意义,提供了一个整体的视觉-语义映射。

这些互补的分析共同形成了一条双重推理路径,提升了模型生成语义基础且可解释输出的能力,即使对于尚未破译的字符也是如此。

下表为,破译结果和可解释性过程展示:

小结一下,在本研究中,团队提出了一种基于部首和象形分析的可解释甲骨文破译框架。

该框架通过三个阶段将字形与意义相连:部首识别与分析、象形分析以及相互分析。

借助提出的部首-象形双重匹配机制,其模型可根据分析结果从字典中筛选出合适的破译候选集,取代直接输出破译结果,从而实现更优的零样本性能。

此外,生成的文本分析可作为可解释内容,为未破译的甲骨文字符提供参考,因此在考古应用中具有巨大潜力。

为支持训练,他们构建了 PD-OBS 数据集,包含 47,157 个注释有甲骨文图像和象形文字分析文本的汉字,为未来研究提供了宝贵资源。

实验结果表明,其方法在破译准确性、泛化能力和可解释性方面均表现出强劲性能。

论文地址:https://arxiv.org/abs/2508.10113

项目地址:https://github.com/PKXX1943/PD-OBS

- 空洞骑士丝之歌苔莓怎么收集 空洞骑士丝之歌苔莓全收集指南 09-08

- 小米16系列背面渲染图曝光:矩形摄像模组 配3颗镜头 09-08

- 2025年和平精英地铁逃生“摸金杯”S1赛季9月开战 09-08

- 《超自然行动组》小熊猫应对及捕捉方法 09-07

- 小米16规格曝光:6.3英寸1.5K屏、搭载骁龙8Gen5! 09-07

- 逆水寒手游x喜羊羊灰太狼联动懒羊羊时装细节首曝! 09-07

- 女子捕捉学院怎么用情书 女子捕捉学院桃子移植情书使用攻略 09-07

- 业界首个!腾讯混元Voyager3D世界模型发布:支持原生3D重建 09-07

- 一部手机、两副耳机:谷歌安卓9月更新升级影音体验,可共享音频 09-07

- 百度地图官宣深度适配小米澎湃OS 3:四大神级功能上线 09-07

-

iPhone17或有隐藏款 镜头模组带副屏

距离苹果秋季发布会越来越近,iPhone17的爆料层出不穷。近日,有消息指出iPhone17可能藏有“隐藏款”惊喜——镜头模组处搭载副屏。若该设计成真,用户无需点亮主屏,瞥一眼手机背面,就能获取时间、电量等关键信息,极大提升便捷性,这一创新设计能否落地,成为大众关注焦点。

-

三角洲行动哪些容器爆率高 三角洲行动高出货容器汇总

《三角洲行动》的资源收集至关重要,而容器搜刮是重中之重。不少玩家苦恼于找不到出货率高的容器,浪费大量时间。其实,大保险柜、航空箱等容器堪称 “宝藏”,出高价值物资概率远超其他。掌握这些高出货容器的位置与特性,能让你在战斗前期迅速武装自己。马上为你揭晓这些出货率高的容器,助你抢占先机 。

-

火影忍者新希怎么玩 火影忍者新希快速上手指南

玩《火影忍者》手游,新希的玩法值得钻研。他在动漫中是砂隐村的新生代忍者,手游里技能设计精妙。普攻五段各有特点,能召唤傀儡、抓取敌人并施加砂铁印记。一技能 “黑铁乃拳” 可远程输出,二技能 “砂之守护” 依据能量条状态,有防御、反击等不同效果。下面,就为你详细讲解新希玩法,助你快速上手,称霸决斗场 。

-

网易云音乐免费送百万黑胶VIP 连续六年举办教师节特别活动

教师节将至,网易云音乐放大招啦!9月5日,其教师节特别活动正式上线,送出100万份教师专属福利大礼包。自2020年起,网易云音乐每年教师节都向教师免费送黑胶VIP,今年福利再度升级。从9月5日至10日,每天中午12点准时开抢,礼包内含网易云270天黑胶VIP、270天听书会员等八大权益,赶紧在网易云音乐APP参与活动吧。

-

iPhone17首发缺席国行AI,苹果17Air或暂无国行市场

9月10日凌晨1点,苹果秋季新品发布会即将开启,iPhone17系列无疑是全场焦点。但令人遗憾的是,此前备受期待的国行AI功能,并不会随着iPhone17首发亮相。据马克・古尔曼透露,苹果仍在努力推进AppleIntelligence在中国的发布,预计要到年底才能上线。国行AI整合了阿里巴巴、百度的大模型,受监管等因素影响,落地进程一再推迟。